Автор статьи – наш приглашенный спецкор Дмитрий Сираков – Data Science Engineer и автор крутого ML-канала @dimension_ai.

На конференции Turbo ML Conf исследователи из Т-банк неожиданно представили свою LLM. Технического репорта модели пока что нет, так что информация в этой статье прямиком с доклада:

- Модель OPENSOURCE без цензуры на нормальном русском, в ней 8B параметров.

- За основу взяли opensource модель LLama-3.

- Докинули в дообучение много русскоязычных текстов, и в дополнение немного английских, чтобы модель не деградировала. Сделали акцент, что обучали с помощью образовательных текстов (да здравствуют учебники Демидовича).

- Увеличили контекстное окно до 8192 токена с помощью PoSE (Идея основная такая: в классике self-attention не учитывает позицию векторов отдельно. Просто к эмбеддингам токенов прибавляют эмбеддинг их позиции. А тут разработчики зашили позиционные эмбеддинги напрямую в self-attention. Теперь там не только Query-Key-Value [тут оч классная статья, которая поясняет это] матрицы, но и position-aware матрица. Это и позволяет дешево увеличить контекстное окно.)

- Использовали токенизатор TikToken от OpenAI, дополнив его новыми токенами, чтобы он лучше работал на русских текстах. Начальные значения токенов были усреднены из старых токенов.

- Использовали две стадии для настройки человеческих предпочтений (формально, это умение модели удовлетворять запросам пользователей):

- SPiN на ответах модели-учителя (Strong Model > Our Model) (Идея: использует сильную модель как эталон для обучения собственной модели. Проще говоря: маленькая моделька учится повторять ответы бОльшей и более умной модели)

- SLiC-HF с использованием своего RM (Идея: Модель генерирует несколько вариантов ответа -> специальная ранжирующая модель выбирает лучший)

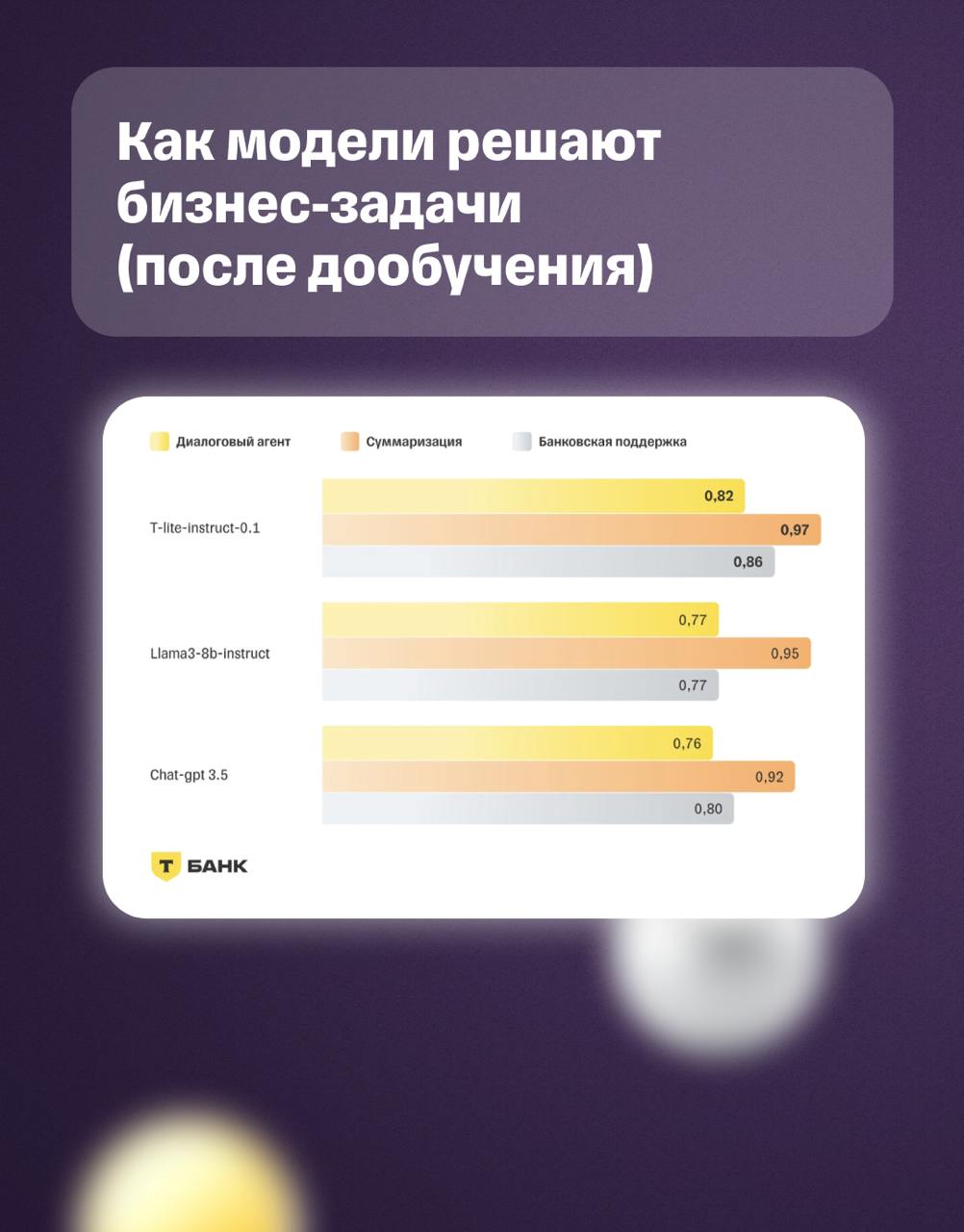

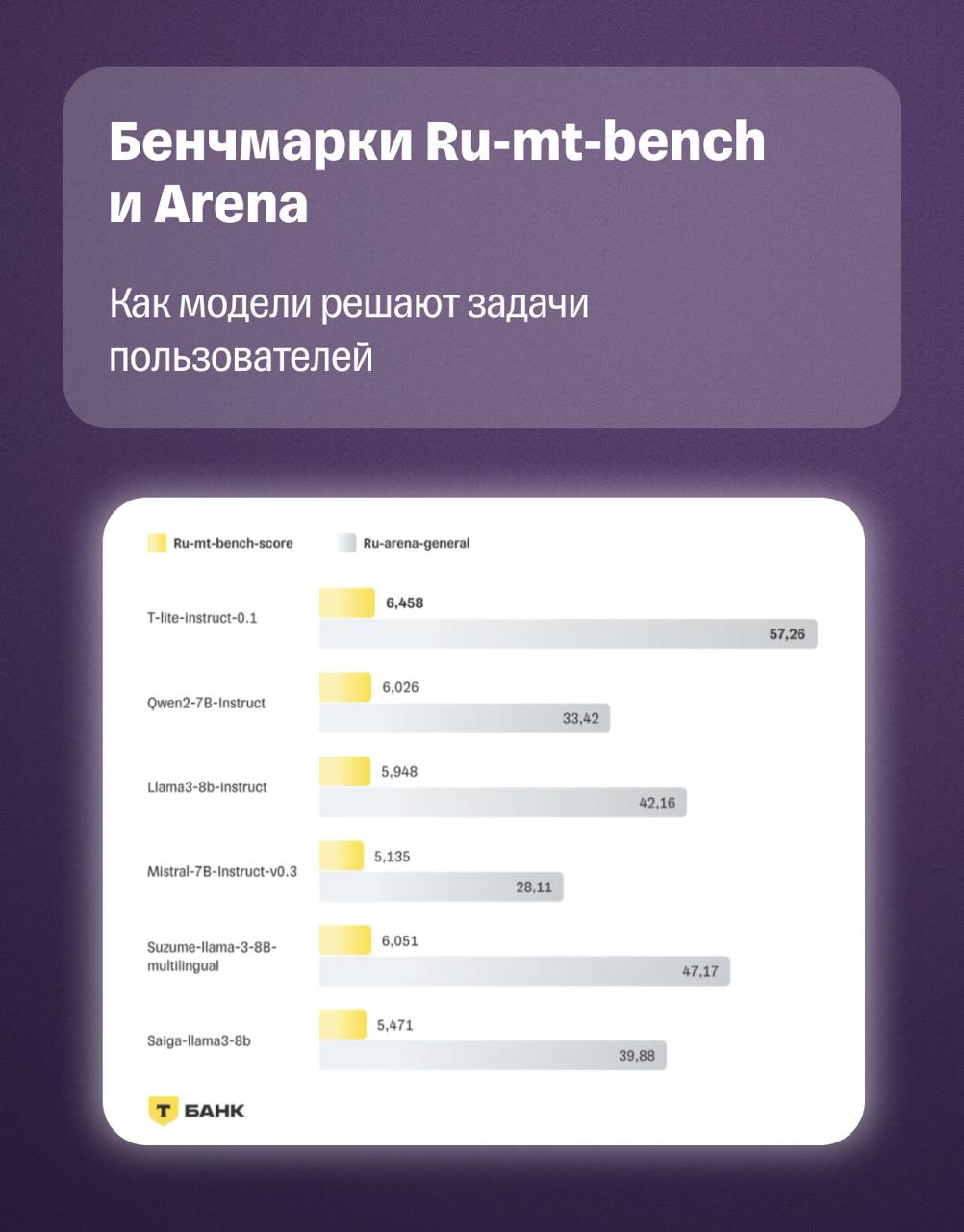

Модель по бенчмаркам показывает себя даже лучше GPT-3.5 / LLama-3 / GigaChat / YandexGPT на финтах задачах: например, суммаризация кейсов.

На такой результат банк потратил всего 3% вычислительных ресурсов (относительно того, сколько обычно выделяют ресов для обучения таких моделей, это совсем крошечное число).

На такой результат банк потратил всего 3% вычислительных ресурсов (относительно того, сколько обычно выделяют ресов для обучения таких моделей, это совсем крошечное число).

НО не всё так радужно. Средний ответ модели почти в 1.5 раза больше, чем у других LLM (например, Gemma или Saiga). Как следствие - метрики завышены, ведь бОльшие ответы, естественно, содержат большее количество информации (но и большее количество воды).

Тем не менее, это прекрасный результат и прекрасная моделька на русском. Радует, что список BigTech компаний, создающих свои LLM, пополнился!