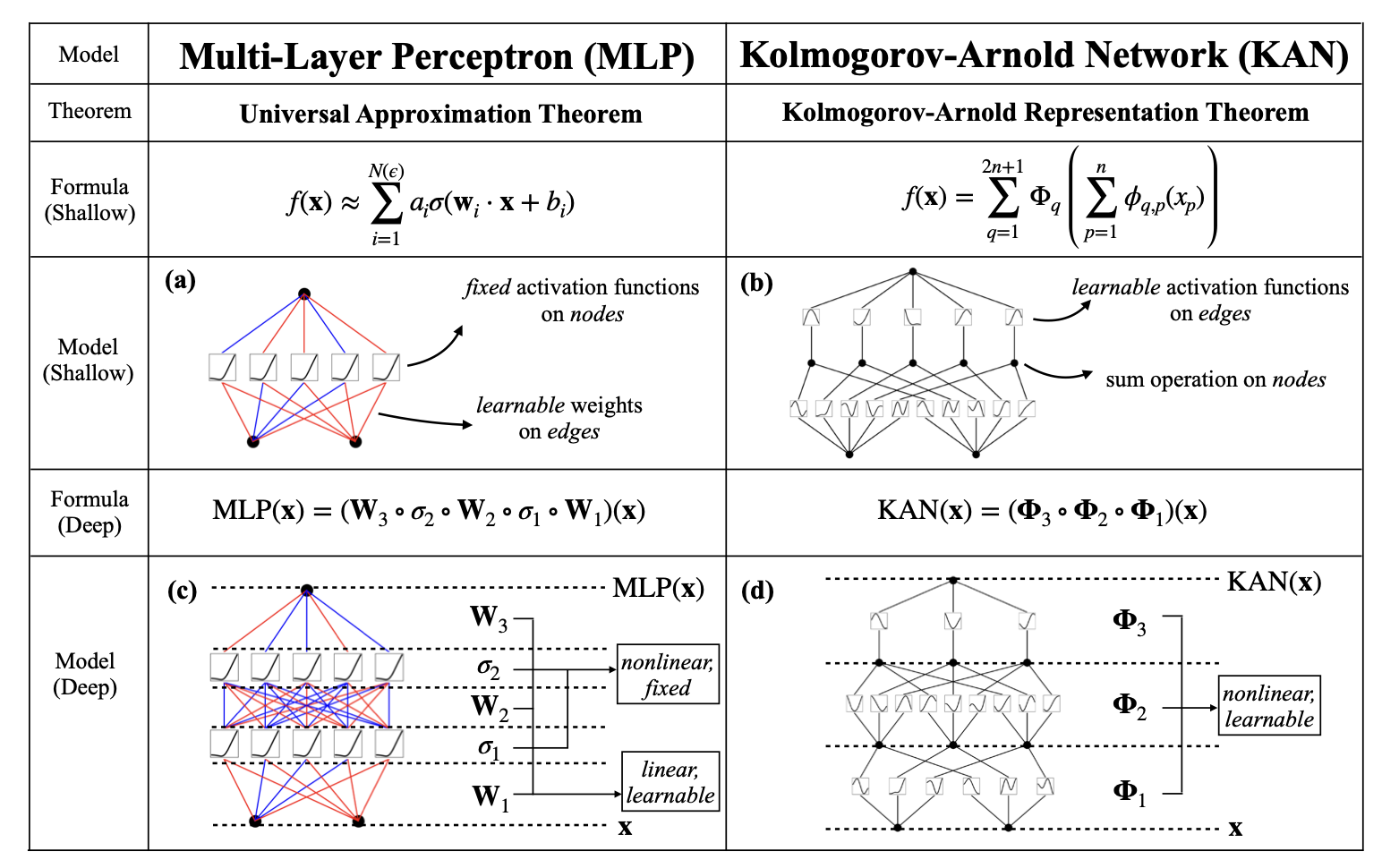

В основе всех архитектур глубокого обучения, в том числе систем компьютерного зрения и больших языковых моделей, лежит многослойный перцептрон (MLP). У него есть веса и нейроны, в которых расположены функции активации. Этой парадигмой ученые пользуются с 1957 года, когда ее предложил Фрэнк Розенблатт.

Сейчас, спустя 67 лет, исследователи представили альтернативу MLP – новую архитектуру нейронной сети, получившую название Kolmogorov-Arnold Networks (KAN), в которой реализовано перемещение активаций на «ребра» сети.

То есть, в то время как MLP имеют детерминированные функции активации в нейронах, в KAN они перемещены непосредственно на веса внутри сети и становятся объектами обучения. В работе подчеркивается, что идея KAN основана на глубоких математических принципах: в частности, на теореме об аппроксимации Колмогорова-Арнольда.

То есть, в то время как MLP имеют детерминированные функции активации в нейронах, в KAN они перемещены непосредственно на веса внутри сети и становятся объектами обучения. В работе подчеркивается, что идея KAN основана на глубоких математических принципах: в частности, на теореме об аппроксимации Колмогорова-Арнольда.

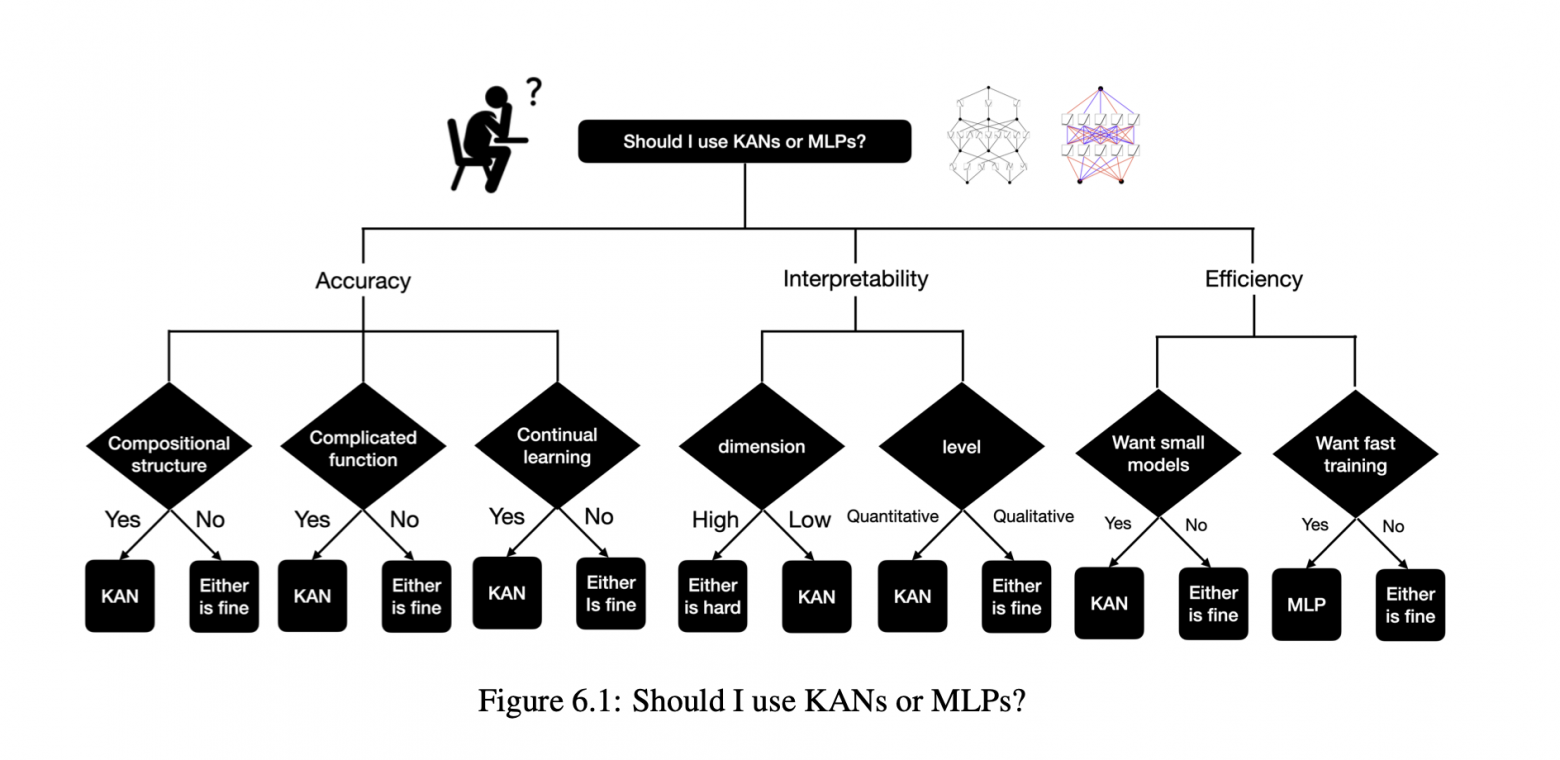

KAN продемонстрировала значительные преимущества в точности перед многослойным перцептроном. При этом для достижения равного результата размер таких сетей может быть значительно меньше по сравнению с MLP. Кроме того, за счет своей гибкости подход предоставляет новые возможности интерпретируемости сети.

Однако стоит отметить, что по сравнению с традиционным MLP обучение KAN занимает больше времени и требует больших вычислительных мощностей из-за сложности обучаемых активаций.

Тем не менее, KAN становится многообещающей альтернативой MLP и открывает новые возможности для улучшения существующих моделей. Это может значительно повлиять на развитие технологий искусственного интеллекта в ближайшем будущем. Возможно сегодня мы наблюдаем зарождение новой эры глубокого обучения.

Тем не менее, KAN становится многообещающей альтернативой MLP и открывает новые возможности для улучшения существующих моделей. Это может значительно повлиять на развитие технологий искусственного интеллекта в ближайшем будущем. Возможно сегодня мы наблюдаем зарождение новой эры глубокого обучения.